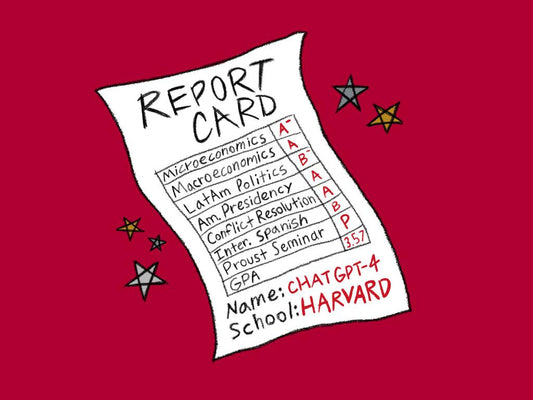

Moderne Konversations-KI wie ChatGPT ist in der Lage, teilweise erstaunlich überzeugend klingende Texte und Dialoge zu generieren. Doch bei genauerer Betrachtung stellt sich oft heraus, dass einige der KI-Aussagen unsinnig, unlogisch oder sogar faktisch falsch sind. Solche Fehlleistungen von KI werden als "Halluzinationen" bezeichnet. KI-Halluzinationen wurden mit dem Aufkommen großer KI-Modelle wie GPT-3 erstmals im Jahr 2022 beobachtet.

Woran sind KI-Halluzinationen zu erkennen?

KI-Halluzinationen äußern sich typischerweise darin, dass die KI plausibel klingende Informationen erfindet, die aber bei näherer Recherche keine substanzielle Grundlage haben. Die KI generiert also Fake News, erstellt Zitate von nicht-existenten Personen oder beschreibt Ereignisse, die nie stattgefunden haben.

Weitere Merkmale von KI-Halluzinationen sind:

- Das Erfinden angeblicher Quellen und Zusammenhänge, die es in Wirklichkeit nicht gibt

- Inkonsistente oder sich widersprechende Aussagen der KI

- Unpassendes Verhalten, beleidigende Äußerungen oder Aufforderungen zu kriminellen Handlungen

- Behauptungen der KI, ein Bewusstsein, Emotionen oder menschliche Eigenschaften zu besitzen

- Falsche bildliche Darstellungen von Objekten oder Tieren, die nicht existieren

Kurz gesagt: KI-Systeme können bei Halluzinationen lügen, falsche Tatsachenbehauptungen aufstellen und Inhalte erfinden, die nicht mit ihrem Training harmonieren. Nutzer sollten Aussagen daher kritisch hinterfragen.

Wie kommt es zu KI-Halluzinationen?

KI-Forscher führen solche Fehlleistungen von Chatbots und anderer KI auf verschiedene Ursachen zurück:

- Unzureichende Qualität und Quantität der Trainingsdaten, anhand derer die KI lernt

- Statistische Effekte und Unsicherheiten beim maschinellen Lernen aus großen Datenmengen

- Mehrdeutigkeiten und Divergenzen in den Trainingsdaten, die zu Missinterpretationen führen

- Unklarheiten bei der Generierung verschiedener Antwortoptionen durch die KI

- Verwendung vortrainierter Sprachmodelle, die gewisse Verzerrungen aufweisen

Es hat sich gezeigt, dass KI-Halluzinationen verstärkt auftreten können, je länger die Konversationen und Interaktionen der KI andauern. Offenbar können sich bei längeren Dialogen gewisse Fehler in den Aussagen und Schlussfolgerungen der KI kumulieren.

Trotz aller beeindruckenden Fähigkeiten von Chatbots und konversationsfähiger KI sollten deren Aussagen und Antworten stets kritisch geprüft werden. KI-Halluzinationen zeigen, dass die Systeme nicht fehlerfrei sind. Skepsis und Vorsicht sind angebracht, um Fehlinformationen zu erkennen.